Im neu gestarteten Projekt entwickeln das Robotics Innovation Center und der Bereich Kognitive Assistenzsysteme eine adaptive, selbstlernende Plattform, die verschiedenste Arten der aktiven Interaktion ermöglicht und in der Lage ist, aus Gestik, Sprache, Augenbewegungen und aus der Gehirnaktivität die Intention des Menschen abzuleiten. Der Projekt-Kick-off fand am 20. Juli 2020 als virtuelle Veranstaltung statt.

DFKI-CEO Prof. Dr. Antonio Krüger, Leiter Forschungsbereich Kognitive Assistenzsysteme und Projektleiter: „In EXPECT bündelt das DFKI Kompetenzen und Expertise aus den Bereichen Kognitive Assistenzsysteme und Robotik an den Standorten Saarbrücken und Bremen. Damit schaffen wir einen Grundpfeiler für weitere anwendungsorientierte Projekte auf der Basis von Forschungsarbeiten zur Einbindung von EEG-Daten in hybriden Brain-Computer-Interfaces.“

Das DFKI gehört zu den Pionieren der mobilen multimodalen Nutzung von EEG Daten für die Interaktion mit robotischen Systemen. „In der Zukunft werden KI-Systeme den Menschen nicht nur in eingeschränkten Bereichen unterstützen. Sie werden vielmehr wie persönliche Assistenten agieren. Um dieser Aufgabe gerecht zu werden, ist es zwingend notwendig, dass sie den Menschen verstehen, seine Intentionen ableiten und kontextsensitiv unterstützen. Gehirndaten eröffnen die Möglichkeit, dem Roboter einen besseren direkten Einblick in die Intentionen des Menschen zu gewähren. Ein wichtiges Anwendungsgebiet ist z.B. die Rehabilitation nach Schlaganfall“, so Dr. Elsa Kirchner, Projektleiterin für den Forschungsbereich Robotics Innovation Center.

Eine der größten Herausforderungen in der Mensch-Roboter-Kollaboration (MRK) ist die natürliche Interaktion. Im Bereich der Mensch-Computer-Interaktion (MCI) beschreibt das Wort „natürlich“ dabei nicht die Schnittstelle zur Interaktion selbst, sondern vielmehr den Prozess des Nutzers, die verschiedenen Interaktionsprinzipien der Schnittstelle zu erlernen. Dieser Lernprozess sollte dabei für den Nutzer so einfach wie möglich erfolgen, basierend auf bekannten (natürlichen) Interaktionsprinzipien, wie Sprachbefehlen, Gesten und ähnliches.

Diese Art der Interaktion ist im Bereich der Mensch-Roboter-Kollaboration von großer Bedeutung. Sie ermöglicht es, die Zusammenarbeit so effizient wie möglich zu gestalten und trägt dazu bei, Berührungsängste und generelles Misstrauen des menschlichen Kollaborationspartners gegenüber Robotersystemen im Arbeitsalltag abzubauen. Damit hat EXPECT einen direkten positiven Einfluss auf die verstärkt auftretende Kollaboration von Mensch und Roboter in der Arbeitswelt.

Um dies zu ermöglichen, werden in dem Vorhaben Methoden zur automatisierten Kennzeichnung und gemeinsamen Auswertung der multimodalen Daten des Menschen entwickelt und in Testszenarien evaluiert. Die systematischen Experimente dienen auch der Untersuchung der Frage, wie grundlegend bedeutsam Gehirndaten zur Intentionsvorhersage beim Menschen sind.

Maurice Rekrut, Projektleiter für den Forschungsbereich Kognitive Assistenzsysteme: „Im Projekt EXPECT untersuchen wir, inwieweit wir in der Gehirnaktivität Korrelationen zwischen unterschiedlichen Modalitäten finden können und damit die Mensch-Roboter-Interaktion intuitiver und natürlicher gestalten können. Zum einen möchten wir rein Brain-Computer-Interface-basierte Interaktionskonzepte gestalten, zum anderen aber auch multimodale Konzepte, um in jeder Situation die bestmögliche Interaktionsmöglichkeit bereitstellen zu können.“

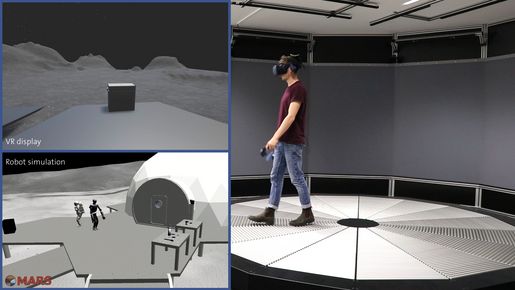

Die in EXPECT zu entwickelnden Technologien können vielseitig Verwendung finden – so zum Beispiel in der Raumfahrt und extraterrestrischen Exploration, der robotergestützten Rehabilitation und Assistenz sowie in Industrie 4.0 und der industriellen MRK.

Projekt-Informationen

EXPECT wird vom Bundesministerium für Bildung und Forschung (BMBF) im Rahmen des Programms IKT-Forschung unter dem Förderkennzeichen 01IW20003 mit einem Volumen von 1,6 Mio. Euro über eine Laufzeit von vier Jahren gefördert.

Weitere Informationen

https://www.dfki.de/web/forschung/projekte-publikationen/projekte-uebersicht/projekt/expect