Idee

Beschreibung

|

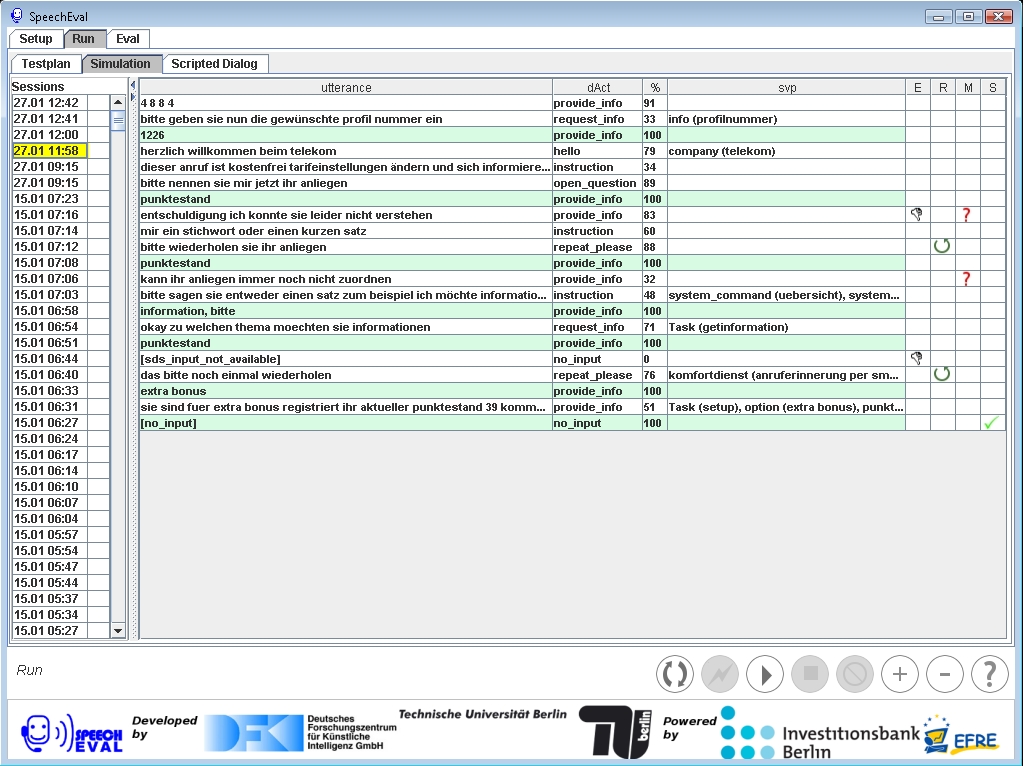

| Erfolgreiche Simulation |

Sprachdialogsysteme gewinnen zunehmen an Bedeutung für Telekommunikationsservices in allen Bereichen. Das macht eine schnelle und ökonomische Entwicklung und Evaluation dieser Systeme erforderlich. Zur Zeit werden zwei Aspekte separat evaluiert. Der erste besteht im Testen der Effizienz individueller Systemkomponents (z.B., Spracherkenning, Verständnis natürlicher Sprache, Dialogmanagement und Sprachsynthese) oder des gesamten Systems. Diese Tests können für einzelne Komponenten automatisch oder halb-automatisch durchgeführt werden, für komplette Dialogsysteme aber konnte bis jetzt keine vollständige automatische Evaluation ohne menschliche Gutachter realisiert werden. Der zweite Aspekt betrifft die Bewertung qualitativer Maße wie Effiziens, Bedienbarkeit und Akzeptanz. Da Qualität das Ergebnis von perzeptiven und wertenden Prozessen ist, verlangt die Bemessung von Qualitätsaspekten normalerweise kontrolliertes Testen mit Versuchspersonen.

Das Projekt SpeechEval eröffnet einen neuen Ansatz für die Beurteilung von Qualität und Benutzerfreundlichkeit von Dialogystemen mit minimalem menschlichen Input, so dass schon während der Designphase Tests durchgeführt werden können;. Wir haben eine Plattform entwickelt, die eine halb-automatische Evaluation von Dialogsystemen nach den oben genannten Aspekten erlaubt.

Dafür haben wir statistische Methoden genutzt, um aus einem allgemeinen Mensch-Maschine Dialog-Korpus Benutzerverhalten zu extrahieren. Das erlaubt uns Benutzerverhalten zu modellieren und zu simulieren, selbst bei Interaktionen mit neuen oder unbekannten Systemen und Domänen. Dieser Ansatz wurde durch die Durchführung von black-box Tests mit real eingesetzten Sprachdialogsystemen validiert.